讲座时间:2024年03月19日(星期二)下午16:00

讲座地点:犀浦校区3号教学楼X31541会议室

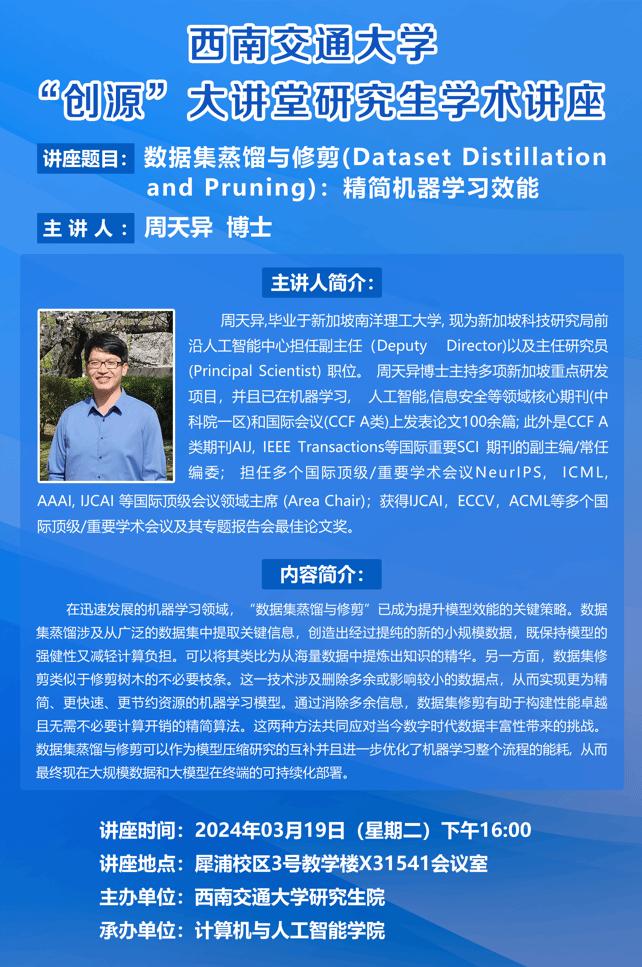

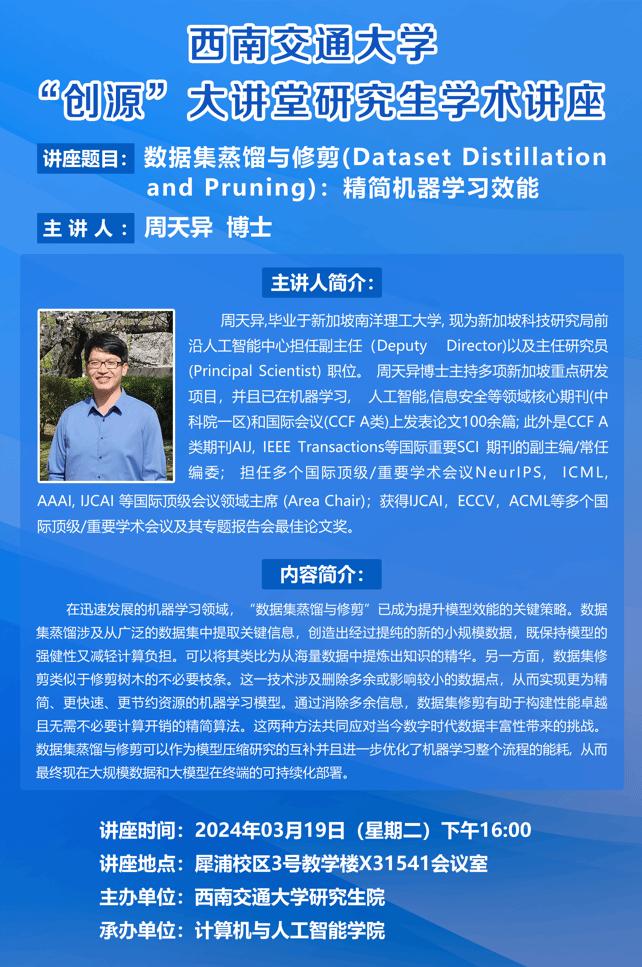

主讲人:周天异博士

主讲人简介:

周天异,毕业于新加坡南洋理工大学,现为新加坡科技研究局前沿人工智能中心担任副主任(Deputy Director)以及主任研究员(Principal Scientist)职位。 周天异博士主持多项新加坡重点研发项目,并且已在机器学习,人工智能,信息安全等领域核心期刊(中科院一区)和国际会议(CCF A类)上发表论文100余篇;此外是CCF A类期刊AIJ, IEEE Transactions等国际重要SCI期刊的副主编/常任编委;担任多个国际顶级/重要学术会议NeurIPS, ICML, ICLR, AAAI, IJCAI等国际顶级会议领域主席(Area Chair);获得IJCAI,ECCV,ACML等多个国际顶级/重要学术会议及其专题报告会最佳论文奖。

内容简介:

在迅速发展的机器学习领域,“数据集蒸馏与修剪”已成为提升模型效能的关键策略。数据集蒸馏涉及从广泛的数据集中提取关键信息,创造出经过提纯的新的小规模数据,既保持模型的强健性又减轻计算负担。可以将其类比为从海量数据中提炼出知识的精华。另一方面,数据集修剪类似于修剪树木的不必要枝条。这一技术涉及删除多余或影响较小的数据点,从而实现更为精简、更快速、更节约资源的机器学习模型。通过消除多余信息,数据集修剪有助于构建性能卓越且无需不必要计算开销的精简算法。这两种方法共同应对当今数字时代数据丰富性带来的挑战。数据集蒸馏与修剪可以作为模型压缩研究的互补并且进一步优化了机器学习整个流程的能耗,从而最终现在大规模数据和大模型在终端的可持续化部署。